Tous ses utilisateurs sont en train de l’admettre : les réponses de l’IA générative manquent parfois de pertinence et c’est parfois dangereux. Pour mieux l’utiliser, pour contribuer à améliorer ses versions francophones, le ministère de la Culture vient de lancer un comparateur en ligne : compar:IA

Utilisateurs occasionnels de l’Intelligence artificielle générative, nous avons pu constater, chez Wazup-Intech, plusieurs failles de pertinence dans les réponses à nos prompts qui auraient pu avoir des conséquences significatives si nous n’avions pas pris la peine de vérifier et de contrôler en sollicitant classiquement les moteurs de recherche. Dorénavant, chacun peut solliciter un nouvel outil mis en ligne par le ministère de la Culture : un comparateur d’IA. Parce que, justifie le ministère « Il ne faut pas se fier aux réponses d’une seule IA »…

Un problème de pertinence

Voici quelques exemples vécus dans notre activité professionnelle pour vous montrer combien l’IA générative doit être utilisée avec prudence et combien la comparaison d’au moins deux IA, suggérée par le ministère, est pertinente.

- Par exemple, alors que je demandais à ChatGPT de rédiger un exemple de lettre ouverte à un ministre précis, la version proposée débutait par « Chère madame la ministre ». Double problème de taille car cette familiarité ne s’utilise jamais dans ce type de courrier, et – surtout – le ministre potentiellement destinataire à l’époque était un homme ! J’apprenais à mes dépens que GPT est programmé pour toujours fournir une réponse, voire l’inventer s’il n’en trouve pas et ne jamais croiser ni vérifier ses informations ! Contrairement aux journalistes…

- Autre exemple, recherchant des innovations lors d’un salon dont l’édition s’achevait (ce qui était précisé dans le prompt), les exemples donnés en réponses relevaient de salons précédents sans que cela soit précisé.

- Une autre fois, cherchant à retrouver la déclaration d’un grand dirigeant d’une multinationale, ChatGPT me fournit une citation précise qui – vérification faite – n’avait jamais été prononcée par l’intéressé lors de l’événement concerné.

- Une autre fois, demandant en 2024 des données statistiques européennes, les réponses proposées n’étaient pas plus récentes que 2022, malgré mon insistance à avoir des chiffres actualisés. Il faudra que j’insiste pour que ChatGPT « avoue » ne pas avoir accès aux données postérieures à 2022, ce qu’il aurait dû faire de lui-même.

Ces quelques exemples pour démontrer les fréquentes failles, voire les dangers de l’IA générative et donc la nécessité à la fois de contrôler ses réponses et, mieux encore, de les comparer.

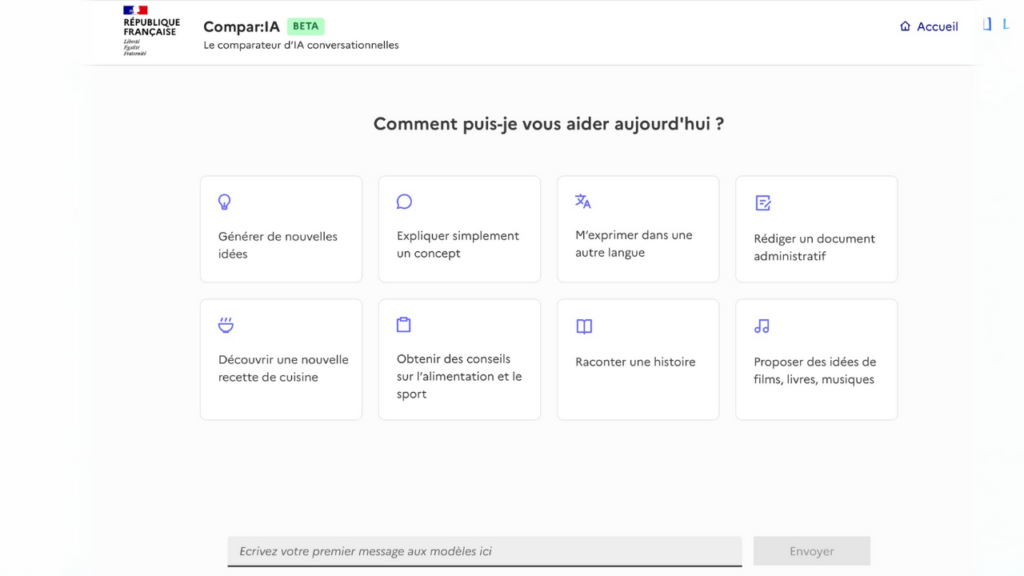

Compar:IA, pour comparer à l’aveugle

C’est justement l’objectif de l’initiative lancée par le ministère de la Culture dont la Direction du Numérique vient de mettre en ligne la version Beta d’un « Comparateur d’IA » GRATUIT dénommé Compar:IA. Son utilisation et la finalité sont simples, claires et ambitieuses.

- Côté usage, il permet de solliciter simultanément deux IA génératives anonymes sur un même sujet et aussi longtemps que nécessaire et de comparer la pertinence des réponses. Après quoi, les IA sollicitées sont dévoilées et leurs caractéristiques respectives expliquées.

- Côté finalité, l’utilisateur est invité à indiquer la meilleure réponse afin d’alimenter un jeu de données, en français, concernant des utilisations du quotidien. La diffusion de ces données permettra d’améliorer la qualité des modèles de langage conversationnels en usage francophone.

Autre finalité revendiquée : « Encourager l’esprit critique des utilisateurs en rendant effectif un droit au pluralisme des modèles.

16 modèles d’IA pour comparer

La plateforme a référencé 16 modèles d’IA, dont certaines sont des déclinaisons d’autres. On y trouve notamment plusieurs versions de Mixtral et Mistral Nemo, du français Mistral, de Llama (Meta), de Gemma et Gemini (Google), ou encore Chocolatine (Jpacifico), Nous (Hermès), LFM (Liquid), Phi de Microsoft et Qwen (Alibaba).

Un problème de biais

Car pour le ministère de la Culture, l’une des raisons – ce n’est la seule, on l’a vu – pour lesquelles nos IA génératives ne sont pas suffisamment pertinentes tient dans le biais linguistique et culturel. En clair, précise la Direction du Numérique :

« Les IA conversationnelles reposent sur des grands modèles de langage (LLM) entraînés principalement sur des données en anglais, ce qui crée des biais linguistiques et culturels dans les résultats qu’ils produisent. Ces biais peuvent se traduire par des réponses partielles voire incorrectes négligeant la diversité des langues et des cultures, notamment francophones et européennes ».

Collecter les préférences des utilisateurs

Comment corriger ce biais et améliorer la pertinence des réponses des agents conversationnels ? En recourant à « l’alignement ». L’alignement est une technique de réduction des biais qui repose sur la collecte des préférences d’utilisateurs en vue d’ajuster les modèles d’IA pour qu’ils génèrent des résultats conformes à des valeurs ou des objectifs spécifiques.